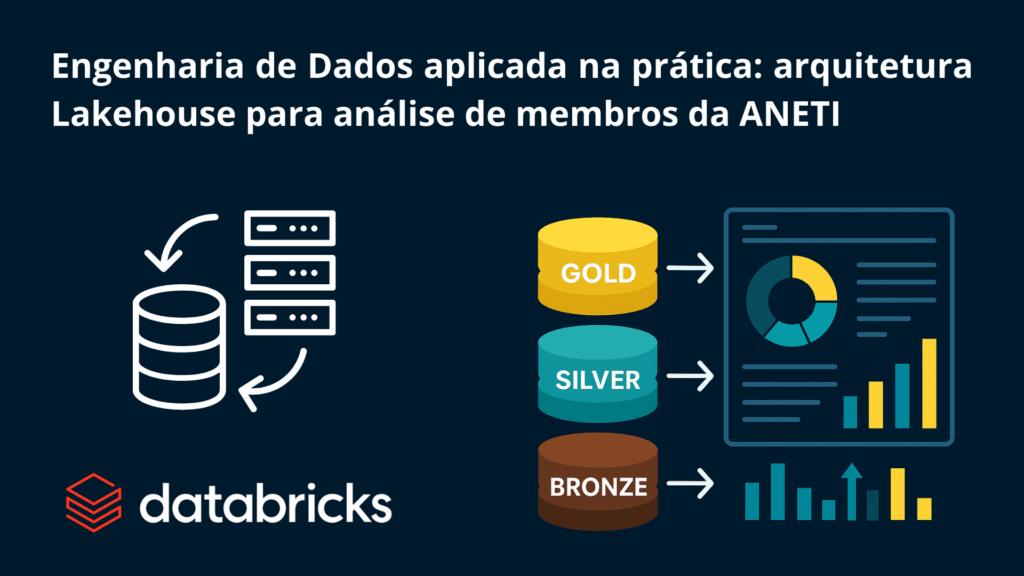

Engenharia de Dados aplicada na prática: arquitetura Lakehouse para análise de membros da ANETI

Nos últimos meses, desenvolvi um pipeline de dados completo dentro do Databricks, aplicando a arquitetura em camadas (Medallion Architecture) para organizar, tratar e entregar insights estratégicos sobre os membros da ANETI (Associação Nacional dos Especialistas em TI), onde também atuo como presidente.

Esse projeto não é apenas técnico — ele tem impacto direto na tomada de decisão institucional, trazendo clareza sobre onde estão nossos membros, em que áreas atuam, como se distribuem por estado, cidade e perfil profissional.

Abaixo, compartilho os detalhes técnicos da implementação.

Estrutura do Catálogo Delta

Toda a estrutura foi organizada no Unity Catalog do Databricks, distribuída por esquemas/layers:

- aneti.bronze

- aneti.silver

- aneti.gold

Cada layer segue um padrão de versionamento, controle de schema e governança, usando Delta Lake para garantir consistência e performance.

Bronze Layer – Raw Data Ingestion

A camada Bronze foi responsável pela ingestão dos dados brutos vindos de múltiplas origens no formato .csv. Os arquivos incluíam:

- membros.csv

- usuarios.csv

- nivel.csv

- perfil_campos.csv

- perfil_dados.csv

Utilizei leitura com spark.read.format(“csv”) com headers e delimitadores bem definidos, sem aplicar nenhuma transformação inicial. O foco aqui foi manter os dados intactos, respeitando o conceito de landing zone. Conforme demonstrado na imagem abaixo:

Silver Layer – Data Cleansing e Unificação

Essa camada foi onde concentrei a maior parte do trabalho de engenharia.

Principais transformações aplicadas:

- Padronização de campos com trim, upper, to_date e when

- Normalização de dados pivotados no perfil do usuário (com pivot via Spark SQL)

- Joins entre múltiplas tabelas utilizando user_id como chave primária

- Remoção de nulos e duplicidades

- Criação da tabela unificada anet.silver.membrosfinal

O resultado foi um dataset confiável, normalizado e padronizado, pronto para análises. Tudo feito com DataFrame API e Spark SQL, garantindo escalabilidade.

Abaixo deixo alguns prints desse processo:

Gold Layer – Métricas e Análises

Na camada Gold, os dados foram agregados, filtrados e preparados para consumo analítico.

Criei diferentes tabelas analíticas, entre elas:

- aneti.gold.membros_por_estado

- aneti.gold.membros_por_area

- aneti.gold.membros_por_cidade

- aneti.gold.membros_estado_area

Técnicas utilizadas:

- .groupBy().count().orderBy() para KPIs

- .filter() para segmentação por relevância (TOP 10 estados, áreas mais representadas, etc.)

- .saveAsTable() com format(“delta”) e mode(“overwrite”)

- Visualizações via Databricks SQL Dashboards com gráficos do tipo donut, bar e mapas

Com isso, construí uma visão gerencial e estratégica dos membros da ANETI, algo até então inexistente na organização.

Tecnologias e conceitos aplicados

- Databricks Lakehouse

- PySpark

- Spark SQL

- Delta Lake

- Unity Catalog

- Medallion Architecture (Bronze / Silver / Gold)

- DataFrame API

- Data Cleansing & Standardization

- Data Aggregation / Modeling / KPI Design

- SQL Analytics & Dashboarding

- Governança de Dados & Versionamento Delta

Resultados visuais

Os gráficos produzidos agora nos permitem responder perguntas como:

- Em quais estados temos mais membros ativos?

- Quais áreas da TI mais aparecem entre os associados?

- Como estamos distribuídos em termos regionais e técnicos?

Isso impacta diretamente ações de expansão regional, eventos, formação de lideranças e até definição de parcerias locais.

Agradecimentos

Esse projeto foi fortemente inspirado e apoiado pela mentoria do Patrick Diorio e pela comunidade da EmpregaDados que vem fazendo um trabalho diferenciado de formação e capacitação de profissionais de dados.

Conclusão

Esse foi um projeto real, com aplicação direta em um ambiente de produção, voltado para gerar impacto prático em uma associação nacional.

Mais do que aplicar ferramentas, foi um exercício de pensar dados como ativos estratégicos — e aplicar engenharia de dados com propósito.

Se você curtiu a ideia, quiser tirar dúvidas técnicas ou trocar experiências sobre arquitetura Lakehouse, Delta Lake ou projetos reais com Databricks, comenta aqui ou chama no inbox. Sempre bom trocar com quem também vive dados no dia a dia.

#EngenhariaDeDados #DataEngineering #Databricks #Lakehouse #PySpark #DeltaLake #MedallionArchitecture #ETL #DataPipeline #SparkSQL #SQLAnalytics #KPI #DataOps #BigData #TIcomDados #CloudDataEngineering #GovernançaDeDados #DataModeling #ANETI #EmpregaDados #PatrickDiorio

Respostas